(旧文)也说王垠退学

好几天前就在网上看到关于王垠从清华退学的新闻。本来我对这类事情是不会去关心的,认为又是媒体的炒作把事情闹大。昨天因为在一个朋友的blog上看到也在讨论这件事,所以忍不住去看了王垠的退学信1。我的第一反应是「原来是他!」。

在多年以前王垠还没有那么出名的时候,我就已经在他的主页上看过他写的关于 GNU/Linux, TeX/LaTeX, 和 Mutt 的文章,当时就觉得他这样一个对计算机科学充满激情的人将来必定有所作为。虽然我接触计算机以及对计算机科学产生浓厚的兴趣比他要早很多,常庆幸自己很早就明白喜欢从事什么行业,不过和他对这些东西的熟悉程度,对不明白的问题的钻研精神,以及那一股狂热劲相比,我真是觉得惭愧。

王垠发表在主页和 blog 上给清华的退学信中说到了很多中国的教育以及中国的大学存在的问题。可以说其中涉及到体制的部分大多数是客观和真实的,是很多学生的亲身体会,甚至可以说要是他到读博士才意识到这些问题,已经有些晚了。一些清华的学生和校友针对王垠的退学信设立了一个 blog -清华梦依然在,集中了一些反面的看法。双方各执一词,其实争论主要是集中在一些细节问题,还有王垠信中对清华和他们实验室两位导师的评价,对中国教育大环境存在的问题,其实很少有人真正持不同意见,只是大家有不同的解释。我不在清华,不了解具体情况,所以对涉及到清华和他们实验室的具体情况,自然没资格评论了。

王垠的信让我回想起自己本科的时候。我在武汉大学读的本科,武大在学术上不如清华,类似王垠说的问题表现得可能还更明显一些。那时候的我年轻气盛,嫉恶如仇,想法和态度大约和现在的王垠差不多:不喜欢很多学校里的教授,看不惯学校的很多事情。我从大二结束以后就很少去上课,因为总是觉得有些不屑,认为学不到什么东西。每个学期系里开什么课,我就去书店买对应的影印版英文教材看,到期末最后一节课去听老师划划重点,然后就去考试。往往到了一个学期结束还问同寝室的同学教某门课的老师是男是女。我虽然不像王垠,但也算是个敢作敢为的人,大四时在 BBS 上发过一些帖子,其中有说到武大的计算机科学系教的不是计算机科学,而就是一个电脑培训班。我们院的党委副书记同时也是 BBS 上院版的副版主,他常常把我封了,有时还打电话到寝室教训我。这种事情发生得多了,后来就成朋友了。将要毕业的时候,校学生会从应届毕业生里面找了包括我在内的三个人去给低年级同学做学习经验交流。当时因为院校合并等一系列事情,学生对学校的怨气挺大的,自由问答的时候有个学生问我学校的种种不好对我有没有什么影响。当时在教五楼的礼堂,我对着下面的几百学生说:“武大要强起来就得靠学生自己。每个学生为着自己的理想去奋斗,每个人都做好自己的事,武大自然就强了。靠现在行政大楼里面那帮人去决策,武大不可能强起来的”,不知道有没有把邀我去的那个学生会学习部的 mm 吓到。那时候我还没有拿到毕业证。

大三时一个在日本工作了多年回到武大的教授对本科生开了一门面向对象软件工程的课,主要讲UML的基础和应用一类的。因为我一向对软件开发很有兴趣,他讲的那些东西当时在国内算是比较新的。那时他的实验室刚重新启动,正在用人之际,他也比较鼓励本科生的参与,而我的专业和英语都还不错,所以从大三的某个时候开始一直到大四结束,我都一直在武汉大学的软件工程国家重点实验室做些事。那里研究生太多,导师也顾不过来,更不用说我这个本科生了。实验室老板对我很好,很照顾,只是他实在太忙,连他自己的研究生都指导不过来。那时我在那里做了很多翻译之类基本没有技术含量的活。科研方面就和王垠说的一样,就是读很多国外的 paper,然后考虑是不是能对一些小的方面进行改进,不可能会有什么突破性的结果。就这样一边做这些事情,一边应付每个学期的考试,一边考 TOEFL,GRE,GRE CS Sub,申请,办出国手续,一直到毕业。

凡事都有两面。王垠做出退学的决定,我想他只看到了一面。我本科时所处的环境,促使我养成了独立学习,独立思考的习惯和能力。我在软件工程实验室虽然常常在做些无谓的事情,不过大量的阅读使我对软件工程发展的概况有了全面的认识。王垠对他实验室的教授有颇多抱怨。本科时有一个数学系的教授在瞒着我的情况下把我交的作为一门课的 term project 的程序带到高交会做演示,后来还是一个去了的人说起我才知道。到后来买方提出一些要求,他因为搞的是数学,不熟悉编程,无法解决,才又来找到我。当时曾因此很不愉快,并非我想从那个程序得到什么商业利益,而是因为我最不喜欢被人欺瞒。可是要是不是因为他开了那门课,我也不太会对那个领域进行深入的学习,也就不会认识我现在的导师。所以要是没有他,我现在会是另外一个情况,或许差一些,或许好一些。人生际遇,从独立的一件事是难以判断祸福的。最重要的是以平和的心态看待问题,不管处于什么样的环境,都要 make the best out of it。

环境的不尽如人意并不是一件坏事,以其说“天将降大任于是人”之类的空话,不如看看真实的例子。很多人说中国的教育体制不能培养出世界一流的科学家,真是这样吗?现在在清华大学高等研究所的王小云在对 MD5 和 SHA-1 等一系列 hash function 的分析方面得到了突破性的进展,现在美国搞 computer science 的人基本都听说过她的名字,密码学界就更不用说了。可以说她和她学生的研究代表着理论密码学的 state of the art。 Wikipedia上说:

At the rump session of CRYPTO 2004, she and co-authors demonstrated collisions in MD5, SHA-0 and other related hash functions. (A collision occurs when two distinct messages result in the same hash function output). They received a standing ovation for their work.

在一个学术会议上,所有人起立为一个 talk 鼓掌,这是很少见的。她的简历上说:

Education:

- B.S., Mathematics Department , Shandong University, 1987.

- M.S., Mathematics Department , Shandong University, 1990.

- Ph. D, Mathematics Department , Shandong University, 1993.

Employment Record:

- Lecturer, Mathematics Department, Shandong University, 7/1993-6/1995.

- Assistant Professor, Mathematics Department, Shandong University, 7/1995-6/2001.9.

- Professor, School of Mathematics & System Sciences, Shandong University,7/2001.9-Present.

她更本没有在国外接收过教育或者做过研究。据我所知,她今年准备去美国参加 CRYPTO’05 的时候还被据签了,她的新成果是 Adi Shamir 代为宣读的。她出生就在山东,从大学一直到成为正教授都一直在山东大学,一所在中国都算不上一流的大学。她的主要成果也是在山东大学信息安全研究中心做出的。清华学生所拥有的环境是让中国很多别的学校的学生羡慕不已的,我想不会不如王小云成长起来的环境吧。客观条件可以起一定作用,可是要成为什么样的人还是取决于自己。王垠说:

我觉得自己一个学生力量太小,曾经试图找大师帮忙。我找到 Andy Yao,述说我的苦衷。结果他对我说:「别试图去改造环境!你没有这个能力。改造好你自己就不错了。」改造好我自己,可是怎么改?所以我决定先换一个环境,到一个真正搞研究的地方去体会,去学习。

其实姚期智说得没有什么不对。在大环境下多数人的力量都是薄弱的,难以去把环境变得让自己喜欢,何况每个人的看法和喜好是不一样的。人不能控制环境,但是可以控制自己,不管环境怎样,始终可以努力做自己想做的事。在觉得出了问题的时候,怪罪于环境之前,恐怕首先要找找主观原因。毕竟在同样或者更不好的环境下,还是有别的人可以做得很好。每个人都把自己份内的事情做好了,环境自然也就变好了。

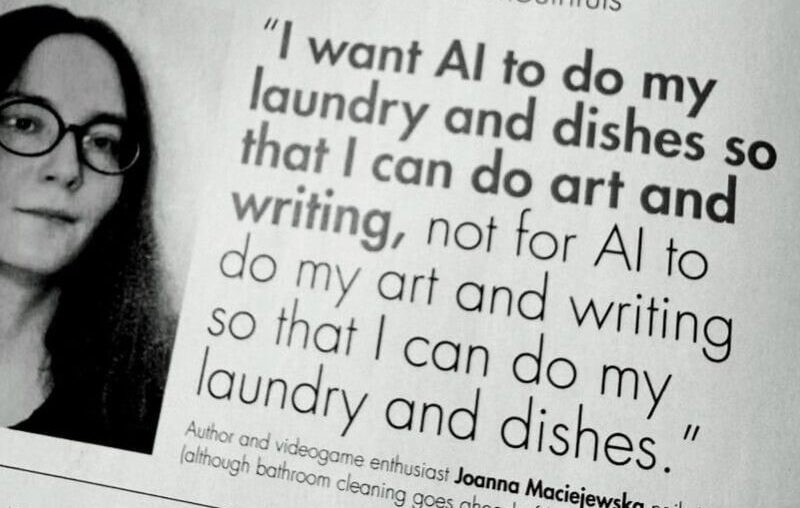

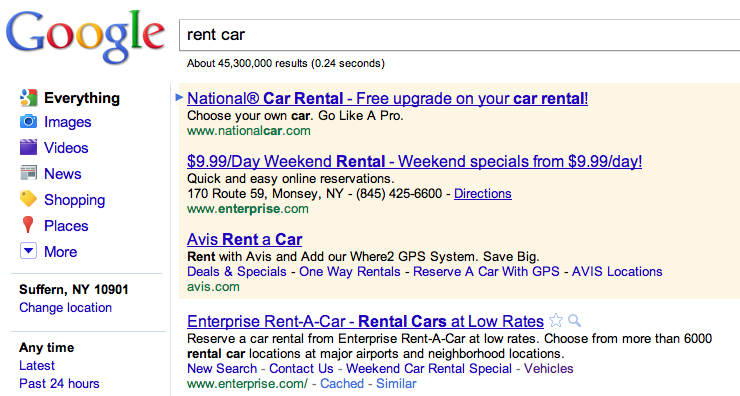

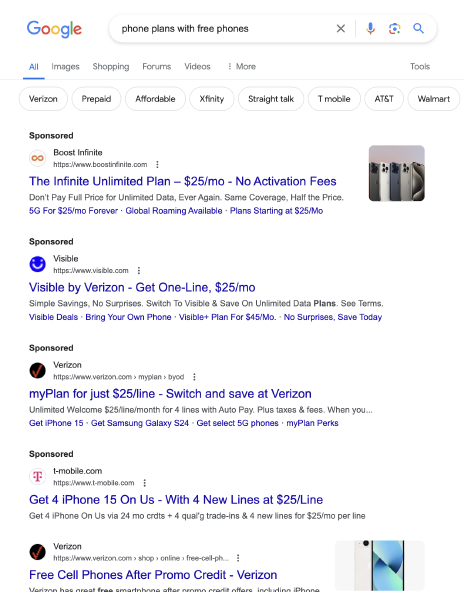

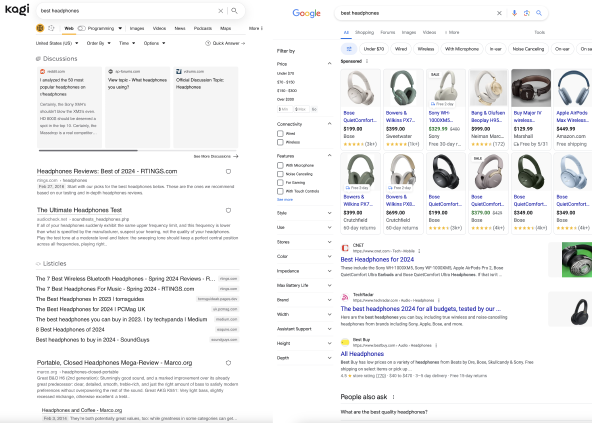

王垠说他打算退学后出国找一个喜欢的学校做他心目中真正的科学研究。我想他会失望的,因为理想的学术殿堂不存在,失望的结果可能有两种,他或许会明白一些事情,从此有一个比较平和的心态;或许会做出更极端的选择。2他信中说的很多问题都是 universal 的,有人的地方都存在这些问题,只是因为中国发展变化得太快,所以各方面的矛盾也表现得更为明显和极端。美国也是一个功利的国家。在美国教授同样要靠发 paper 申请 funding 和拿 tenure,很多研究生同样要做很多无聊的表面工作。很多美国实验室的老板,特别是还没有拿到 tenure 的教授,不管学生愿不愿意都要逼着学生干他觉得需要完成的活,比起国内有过之而无不及。我认识的一些别的学校的中国学生,放暑假想要回国探亲老板都不让,就算让也只给很短的假期。况且在美国你的学费生活费都是靠导师从科研经费出的,和导师关系搞僵了就得卷铺盖走了。3王垠在信中说国外大学都有 common room,而国内没有。另外他觉得学生之间的讨论很重要,而实验室组织的讨论每个学生讲讲对自己看的论文的看法,他又觉得那样的讨论不好。有没有 common room 只是一个形式,形式决定不了内容。我就基本不去 common room ,因为我不喜欢人多的地方,我喜欢一个人静静地思考。有时在走道遇到一个人想说什么事情,就靠着墙一说就是一两个小时,也没有觉得需要一个 common room。在国外大学里的学术讨论其实和他所描述的他们实验室的讨论差不多。通常也就是一个人说一说对某篇论文的看法,经常也是很长时间没有什么结果,很多想法被提出来被否定掉。要找一个他心目中理想的科学研究的殿堂,恐怕穷其一生也找不到。科学研究中的大部分工作都是要静下心来独立完成的。讨论的真正目的是在有一定结果的时候告诉别人,让别人挑刺,所谓的 peer review。他说导师不鼓励学生之间的讨论就不知道别人在做什么,什么已经做了,什么没做,有些什么有趣的问题。以什么样的方式做研究是自己的事,导师鼓励不鼓励只是一个参考意见,毕竟已经不是小学生了。我的导师每个星期和我见一次面,听我说说自己的点子,给我一些指点,除此之外都是我自己安排。我觉得对计算机科学来说,到了博士阶段,正确的研究方式是独立查找资料、独立思考、独立完成工作,这个只是个人的看法,但有一点我可以肯定:要知道他所说的那些东西,最好的方法不是讨论,是 Google。

到现在为止我在美国生活了三年多,最大的收获有两方面,都和学术无关。首先是看到的事情多了,有了比较的基础,心态成熟和平和了很多,看问题不像以前那么片面。另外明白了什么东西才是对自己最重要的。学习,工作,科研并不是对我最重要的,财富也好,学术声誉也好也不是最值得追求的;亲情,友情,爱情,以及一般人之间的关爱才是最值得一个人珍视的。事业只是生活的一部分,生命中有很多珍贵的东西值得去追求,一个人只有首先做好一个普通人,一个普通的好人,他在专业上的expertise才能对社会发挥正面的作用。

我并不是要写那么长一篇文章批评王垠。这三天来正正反反的文章已经很多了,只是联系到自己,颇有感触。对王垠我首先是欣赏的,当年看他写的关于 Linux 和 TeX 的文章,受益很多,现在看到他的退学信,觉得他是个有激情、有勇气的理想主义者。中国需要很多能坚持自己理想,不被环境所同化的人。可是一个人光有理想和激情是不够的,在坚持原则的同时,还要有一颗宽厚、平和、和乐观的心,这样才不会因为对现实的失望而最终放弃自己的理想。我本来不喜欢李敖,不过他在清华的演讲其中一段让我很感动:

富兰克讲了一句话,非常动人,他说,哪里有自由,哪里就是我的祖国。告诉大家,富兰克林是错误的,这句话要被我李敖改写,怎么说,这里是我的国家,我要使它自由。

他说的虽然是自由,不过这段话应用到别的方面也是实用的。中国是问题不少,不过再怎么样总比几十年前好多了吧。如果当年那批知识分子都说:「哇,中国怎么这样?我闪」,那么也就不会有现在这个可以算是(或者说正在变得)繁荣富强的中国。(不要骂我在美国还说得那么虚伪,我是毕业后就要回国的。)古人有句话是「势利纷华,不近者为洁,近之而不染者为尤洁;智械机巧,不知者为高,知之而不用者为尤高。」所以逃避环境并不是最好的选择。最后祝愿王垠在以后的路上可以为自己的心找到一个位置。也希望在这件事平息下来以后,中国的学校,教育者和决策者们能对王垠提出来的问题有认真地思考,不要简单地归咎于一方。